Intelligence artificielle générative

La présence de systèmes d’intelligence artificielle générative en enseignement supérieur soulève de nombreuses questions. Il importe de mieux comprendre le fonctionnement de ces systèmes pour tenir compte de leur potentiel et de leurs limites.

Qu’est-ce que l’intelligence artificielle générative?

Selon l’Office québécois de la langue française, l’intelligence artificielle (IA) est un «domaine d'étude ayant pour objet la reproduction artificielle des facultés cognitives de l'intelligence humaine dans le but de créer des systèmes ou des machines capables d'exécuter des fonctions relevant normalement de celle-ci».

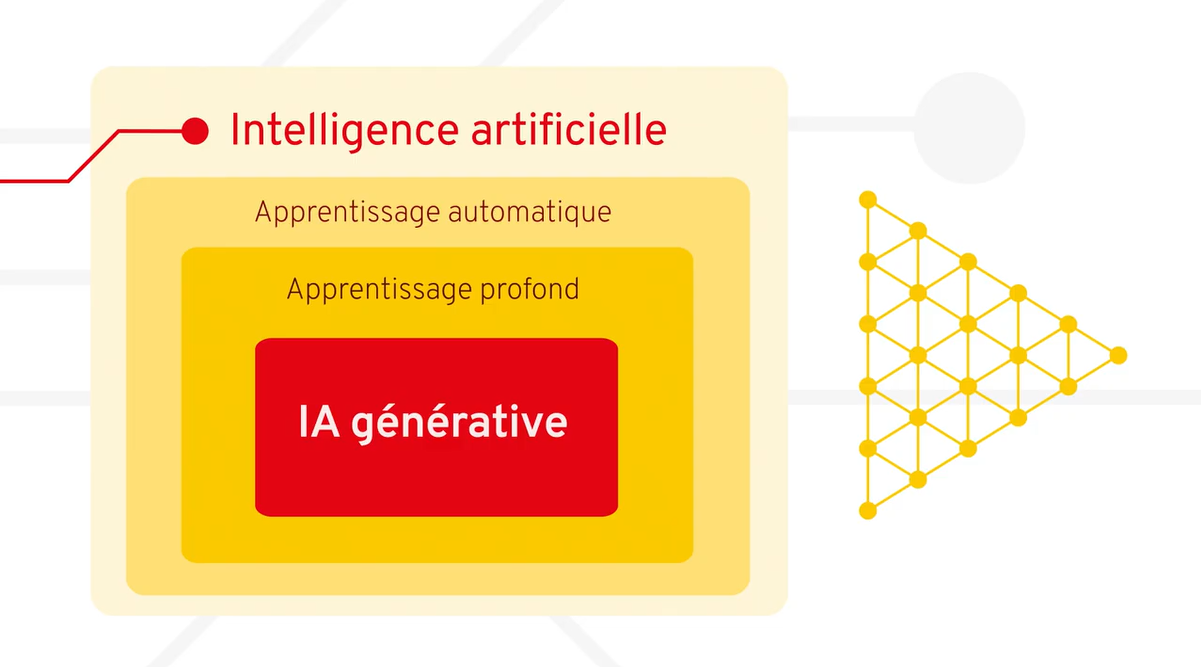

L’IA générative fait partie d’un sous-ensemble de l’IA appelé apprentissage automatique. Ce type d’IA fonctionne sur la base d’un entraînement de la machine à partir de données et sur sa capacité à inférer de ces données des schémas pour en généraliser des concepts sous-jacents.

Au fil des années, de nouveaux algorithmes d’apprentissage ont été inventés, la puissance de calcul des systèmes d’IA a augmenté de manière exponentielle et une quantité massive de données sont devenues disponibles pour soutenir leur entraînement. C’est ainsi qu’a émergé ce qu’on appelle l’apprentissage profond, un mode d’apprentissage effectué par un réseau de neurones artificiels inspiré des réseaux de neurones humains.

L’IA générative est une sous-catégorie de l’apprentissage profond. On parle d’IA générative parce que les données ayant servi à l’entraînement du réseau de neurones permettent à celui-ci de générer de nouveaux contenus pouvant prendre plusieurs formes, par exemple du texte, de la vidéo ou des fichiers audio.

Qu’est-ce qu’un agent conversationnel?

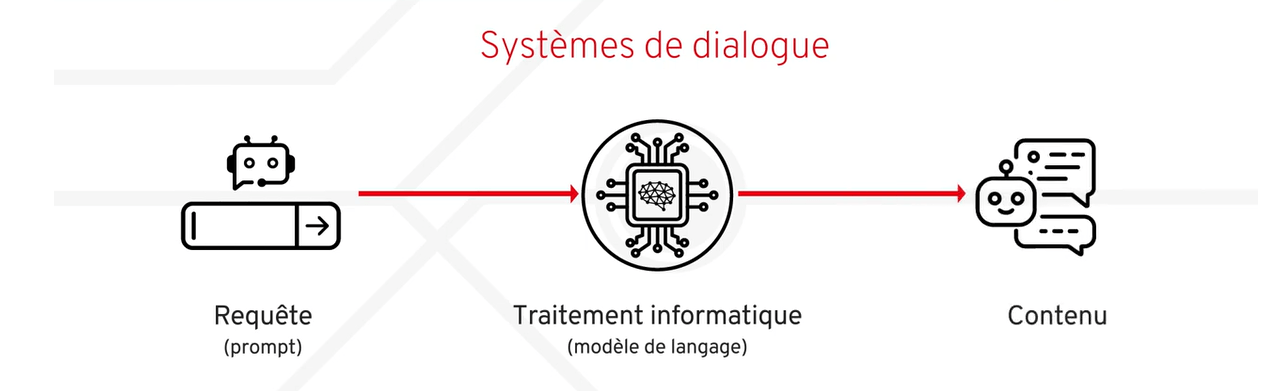

Les agents conversationnels sont les systèmes de dialogue qui permettent d’établir un lien entre la personne utilisatrice et le modèle de langage. Dans une fenêtre de dialogue, la personne rédige sa requête (le prompt), soit une commande textuelle qui précise la tâche à accomplir. La requête est ensuite traitée par le modèle de langage pour générer un contenu.

Le contenu généré est d’abord influencé par une métarequête (ou métaprompt). La métarequête vise à fixer le ton et la structure de la conversation. Ce contenu est aussi influencé par des garde-fous, soit des méthodes qui empêchent la génération de contenus socialement non acceptables (par exemple des contenus violents, sexistes, racistes, etc.). La métarequête et les garde-fous sont établis par la compagnie qui développe le système et diffèrent d’un système à l’autre. En fonction de la métarequête, des garde-fous et de la requête, le modèle de langage prédit la séquence de mot la plus plausible. Par la suite, l’agent conversationnel transmet le contenu textuel généré via la fenêtre de dialogue.

Fonctionnement des agents conversationnels

Un agent conversationnel fonctionne selon un processus itératif. La première étape consiste en la formulation d’une requête initiale et en l’obtention d’une première version de texte généré.

Lorsqu’une première version de contenu a été générée par le système, il est possible, si désiré, de soumettre une nouvelle requête au système, et ce, dans la même fenêtre de dialogue. Ce type de requête, appelé requête d’affinage, est souvent nécessaire pour que les contenus générés répondent bien aux attentes de la personne utilisatrice. La requête initiale et le premier contenu généré sont conservés en mémoire par le système. La nouvelle version générée tient donc compte des échanges précédents.

En formulant de nouvelles requêtes, il est ainsi possible d’affiner la requête initiale ou de la préciser, pour faire évoluer la qualité du contenu généré et qu’il corresponde aux attentes et aux besoins. Par exemple, il est possible de demander que le format de la réponse soit différent, que le vocabulaire soit simplifié ou complexifié, que le nombre de mots soit ajusté ou que des exemples soient insérés.

Se met alors en place un processus d’allers-retours, dans le but d’obtenir un contenu satisfaisant, le tout grâce à de nouvelles requêtes plus précises et plus efficaces.

Mises en garde

Il importe de rappeler que les modèles de langage génèrent des contenus sur la base d’une prédiction statistique : ils ont été entrainés à générer le contenu le plus plausible possible dans un contexte donné. Pour une même requête, les réponses varient donc d’une fois à l’autre et ne sont pas reproductibles à l’identique. Elles sont aussi influencées par la métarequête et les garde-fous, qui varient grandement d’une compagnie à l’autre et influencent le type de contenu généré d’un agent conversationnel à l’autre.

De plus, la validité des contenus générés doit être systématiquement vérifiée, car des éléments incorrects, faux, biaisés ou inventés peuvent y être présents, les systèmes d’intelligence artificielle générative étant des systèmes probabilistes et non factuels. Les données d’entraînement de l’IA générative étant non représentatives de la complexité des réalités sociales et culturelles, les réponses offertes par les agents conversationnels peuvent être biaisées ou inappropriées, tout en étant présentées comme des certitudes.

Enfin, en fonction des données d’entraînement utilisées, les réponses proposées ne tiennent pas toujours compte des plus récentes connaissances sur un sujet donné.

La personne utilisatrice demeure donc toujours responsable de valider les contenus générés et elle est imputable de l’utilisation qu’elle fait de ceux-ci.

Agent conversationnel Copilot à l’Université Laval

L’agent conversationnel Copilot de Microsoft est disponible pour le corps professoral et enseignant, pour la communauté étudiante et pour le personnel administratif. La licence institutionnelle de Microsoft 365 offerte par l'Université Laval permet d’utiliser la version protégée de Copilot et est conforme aux exigences en matière de sécurité et de confidentialité. Vos données sont protégées lorsque vous vous y connectez avec vos identifiants ULaval.

Foire aux questions

Les informations saisies dans les agents conversationnels peuvent être utilisées à des fins d’entraînement et d’amélioration de l’outil. Chaque compagnie détermine un certain niveau de protection des données, niveau de protection qui peut aussi varier selon la version utilisée (gratuite ou payante, par exemple).

Si vous avez des doutes quant à la protection des données lorsque vous utilisez un agent conversationnel, par principe de précaution, nous vous déconseillons fortement d’y saisir toute information confidentielle, nominative, sensible ou tout texte rédigé par une personne étudiante.

Puisque le niveau de protection des données varie grandement et évolue rapidement, nous vous invitons à consulter les pages officielles des compagnies pour en savoir plus.

Vous êtes libre d’utiliser les outils technologiques de votre choix dans le cadre de vos cours. Que vous autorisiez ou non le recours à des outils fonctionnant à l’aide de l’IA générative, il importe de communiquer clairement vos attentes aux personnes étudiantes dans votre plan de cours (voir les modèles proposés). De plus, nous vous encourageons à animer une discussion ouverte en classe sur ce sujet (voir le diaporama proposé, à personnaliser en fonction de vos besoins) ou à tester des requêtes en classe avec les personnes étudiantes. Vous les aiderez ainsi à aiguiser leur regard critique en discutant de la qualité des réponses obtenues et en les comparant avec des contenus présentés dans le cadre du cours ou avec des éléments théoriques connus par l’ensemble du groupe.

Si l’utilisation d’un agent conversationnel est nécessaire dans votre cours, nous vous recommandons d’offrir une alternative aux personnes étudiantes qui ne souhaitent pas créer un compte, considérant les données confidentielles qui sont parfois nécessaires pour ce faire (par exemple, un numéro de téléphone cellulaire). Vous pourriez dans ce cas leur fournir vous-même le contenu généré plutôt que de leur demander de créer un compte.

Vous êtes libre de définir ce qui est permis et ce qui ne l’est pas dans le cadre de vos évaluations. Sachez que si vous décidez de permettre l’utilisation de ces outils, il est important de bien l’encadrer, de spécifier clairement dans le plan de cours (voir les modèles proposés) les tâches qui peuvent être réalisées en s’appuyant sur des outils d’IA ainsi que le type d’utilisation permise.

De plus, nous vous recommandons de discuter de vive voix avec les personnes étudiantes (voir le gabarit proposé à personnaliser en fonction de vos besoins) de l’utilisation de l’IA dans les évaluations, notamment des règles entourant le fait de mentionner et de citer cette utilisation en respectant les normes de référencement.

Si vous envisagez permettre l’utilisation d’outils fonctionnant grâce à l’IA générative dans vos évaluations, par exemple des agents conversationnels, n’oubliez pas de considérer les limites de ceux-ci, notamment l’accessibilité (site parfois inaccessible en forte période d’achalandage) ou les enjeux de confidentialité des données personnelles (numéro de téléphone personnel nécessaire pour créer un compte, par exemple).

L’utilisation d’outils basés sur l’IA ne constitue pas en soi une infraction relative aux études. Si son utilisation a été faite en respectant les attentes mentionnées au plan de cours ou dans les consignes d’une évaluation, il peut s’agir d’une aide autorisée. Dans le cas où cette utilisation n’aurait pas été autorisée explicitement, le fait de s’en servir peut constituer une infraction relative aux études et pourrait mener à l’application des sanctions prévues au Règlement disciplinaire à l’intention des personnes étudiantes de l’Université Laval.

Dans ce type de dossier disciplinaire, la commissaire aux infractions relatives aux études vérifie si elle peut établir la preuve d’une infraction par balance des probabilités, sans nécessairement chercher de preuve spécifique d’une utilisation d’un outil d’IA. L’utilisation d’un outil d’IA peut, de façon générale, être considérée comme une aide non autorisée au sens du Règlement disciplinaire. Selon les faits du dossier, cette infraction peut également être de l’ordre du plagiat, si la personne étudiante n’a pas correctement inséré les citations et/ou références nécessaires, ou de la possession de tout document, appareil ou instrument non autorisé.

L’analyse de la commissaire se centre donc essentiellement sur les faits qui portent la personne responsable du cours à croire que la personne étudiante ne serait pas à l’origine de ce qu’elle a remis. La personne responsable peut fournir toute preuve pertinente à la commissaire. Notamment, ces éléments peuvent être les suivants:

- la copie de la personne étudiante «détonne» de celles des autres membres du groupe

- il y a une amélioration inexpliquée de la qualité de la rédaction

- la personne étudiante utilise des concepts ou des notions qui n’ont pas été enseignés

- les références sont erronées, introuvables ou inexistantes

- etc.

Considérant l’évolution des dossiers disciplinaires reliés à l’IA, plusieurs nuances sont nécessaires et chaque dossier disciplinaire est analysé individuellement et au regard des faits précis du dossier. De ce fait, les exemples de preuves énumérés ci-haut sont pertinents, mais ne sauraient systématiquement conduire à une rétention de l’infraction.

Toute approche misant sur la prévention, que ce soit une mention explicite au plan de cours des utilisations permises ou interdites d’outils d’IA, des discussions ouvertes avec les personnes étudiantes (voir le diaporama proposé, à personnaliser en fonction de vos besoins) ou des efforts mis sur le développement des compétences informationnelles/rédactionnelles/de référencement est bien sûr encouragée.

Sachez que si vous suspectez un cas de tricherie ou de plagiat, vous avez l’obligation de le signaler. À noter qu’il est possible de contacter la commissaire aux infractions relatives aux études via l’adresse institutionnelle discipline.etudes@sg.ulaval.ca afin d'obtenir son opinion avant de procéder à une dénonciation.

Pour plus d’informations au sujet des infractions disciplinaires et du rôle de la commissaire, visitez le site Règles disciplinaires de l’Université Laval.

Les logiciels de détection de l’IA ne sont pas en mesure d’identifier son utilisation à 100% et risquent de donner des réponses ambiguës ou erronées. Il existe également des voies de contournement afin qu’un logiciel de détection de l’IA ne détecte pas ou détecte difficilement l’utilisation de celle-ci. Pour cette raison, l’utilisation de tels outils pour établir la preuve d’une infraction relative aux études n’est pas recommandée.

Une approche misant sur la prévention est encouragée, que ce soit une mention explicite au plan de cours et dans les consignes des utilisations permises ou interdites d’outils basés sur l’IA, une discussion ouverte avec les personnes étudiantes, des efforts consacrés au développement des compétences informationnelles/rédactionnelles/de référencement, etc.

Consultez la page sur les Outils pour la détection du plagiat pour plus d’informations à ce sujet.

Aller plus loin

Observatoire international sur les impacts sociétaux de l’IA et du numérique (OBVIA)

L'Obvia offre de nombreuses ressources à explorer sur les enjeux sociétaux de l’intelligence artificielle et du numérique.

Institut intelligence et données (IID)

L'IID propose plusieurs événements et ressources dans le domaine de l’intelligence artificielle et de la science des données.